Por Qué Tu Equipo Usa la IA en Casa pero la Evita en el Trabajo

Cómo la economía del comportamiento explica está paradoja de adopción digital que la tecnología no lograr resolver

Estás en medio del comité ejecutivo y tu CFO acaba de preguntarte, frente a todo el mundo, por el ROI de los $2.1M invertidos en IA este año.

Tienes unos dashboards hermosos, tres pilotos "exitosos" según IT, y un equipo de transformación digital que asegura estar "avanzando en la curva de adopción".

Pero cuando miras el reporte real: solo hay un 11% de adopción. Después de 18 meses.

La ironía brutal es que conoces a tu equipo. Sabes que la gran mayoría usa ChatGPT en su vida personal. Para planificar vacaciones, resumir artículos, ayudar a sus hijos con tareas.

Algunos incluso lo usan para optimizar sus finanzas personales o escribir correos personales complejos.

Pero en el trabajo, con herramientas corporativas diseñadas específicamente para sus funciones, aprobadas por legal, integradas en sus sistemas... ¡No usan la IA!

La resistencia educada aparece: "Voy a probarlo cuando tenga tiempo." "Prefiero validar con mi método habitual primero."

Y esta es la pregunta que da vueltas por tu mente: ¿Esto es resistencia al cambio... o algo más estructural que estoy ignorando?

No Estás Solo: Es Un Patrón Sistémico

En los últimos 18 meses, hemos diagnosticado 73 empresas latinoamericanas mid-market y enterprise con exactamente este síntoma.

McKinsey lo confirma con datos globales: solo el 23% de las organizaciones que implementaron IA generativa reportan adopción superior al 50% entre sus colaboradores elegibles.

Mientras tanto, el 85% de esos mismos profesionales usan IA regularmente en contextos personales.

Esta no es casualidad ni capricho. Es el resultado predecible de una realidad que pocas organizaciones reconocen:

Tu colaborador no es irracional, de hecho, es profundamente racional.

Y la arquitectura de incentivos, riesgos y consecuencias que diseñaste inadvertidamente está diciéndole, de mil maneras silenciosas, que adoptar IA en el trabajo es una mala apuesta para su carrera, su reputación y su seguridad laboral.

La explicación no está en la tecnología. Está en la economía del comportamiento.

Por qué la adopción de la IA personal es diferente a la adopción laboral

El Cerebro Toma Decisiones Diferentes Según el Contexto

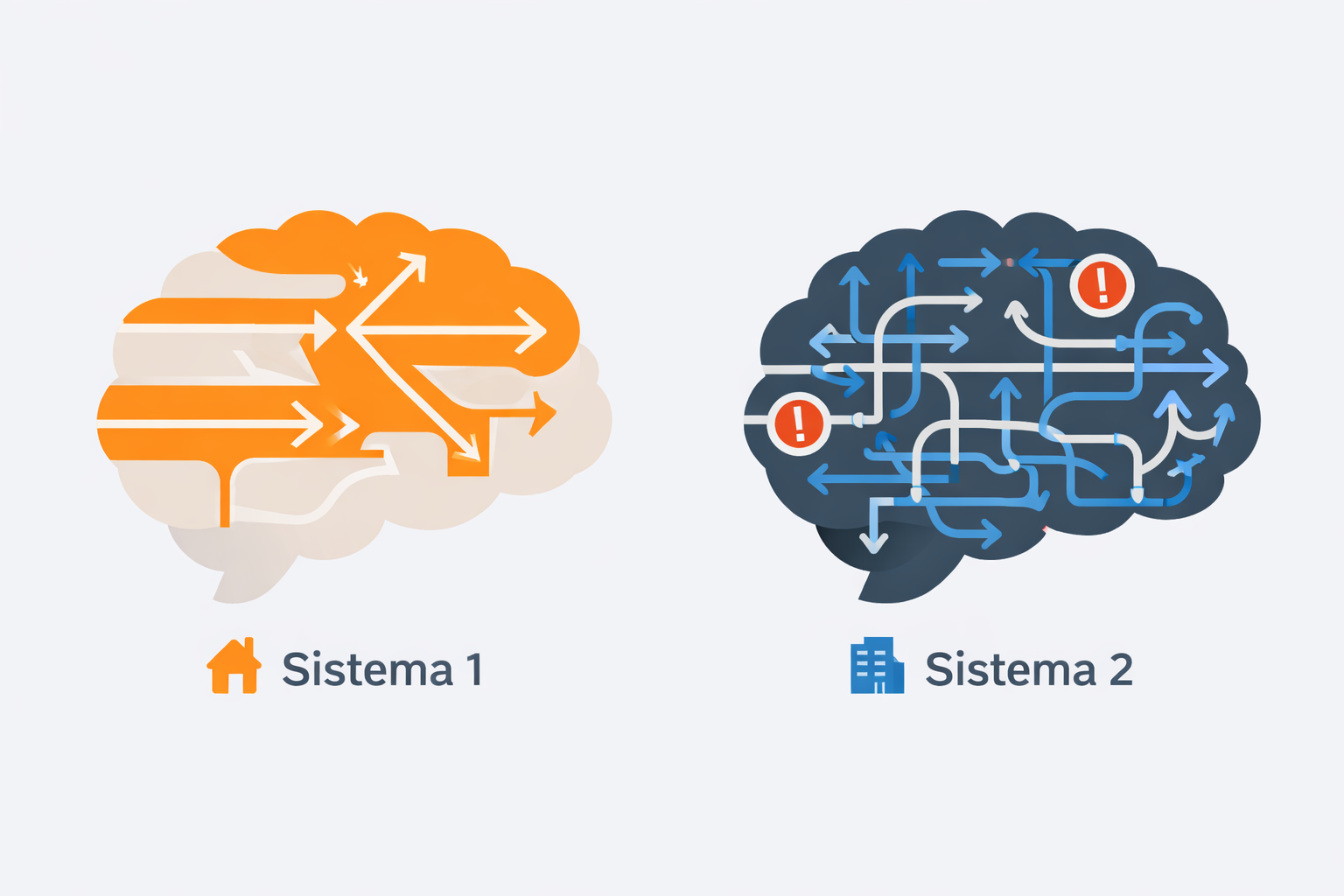

Cuando tu gerente de finanzas usa ChatGPT el domingo para planificar un viaje familiar, su cerebro opera en modo automático e intuitivo. (Sistema 1)

Ve un problema (necesita ideas), reconoce una herramienta sin costo aparente, y actúa. Si la respuesta no sirve, la descarta. Cero consecuencias. Cero escrutinio externo.

El lunes, ese mismo gerente enfrenta usar la plataforma de IA corporativa para un análisis financiero.

Ahora su cerebro activa el modo deliberativo y consciente (Sistema 2) ejecutando un cálculo cognitivo complejo:

- "¿Qué pensará mi jefe si uso esto y me equivoco?"

- "¿Estoy violando alguna política que no entiendo completamente?"

- "Si el output tiene un error, ¿me harán responsable legalmente?"

- "¿Mis colegas me verán como incompetente por no usar el método tradicional?"

- "¿Vale la pena el riesgo versus seguir con Excel que ya domino?"

Este costo cognitivo de evaluar riesgos es tan alto que, paradójicamente, continuar con el método antiguo (aunque objetivamente menos eficiente) se percibe como la opción más óptima mentalmente.

Pérdidas Pesan 2.5 Veces Más Que Ganancias

La investigación en economía del comportamiento demuestra que los seres humanos valoramos las pérdidas aproximadamente 2.5 veces más que las ganancias equivalentes.

Esta asimetría es devastadora para la adopción de IA en el trabajo.

En casa:

- Encuadre = ganancia potencial. "Puedo obtener una respuesta útil sin inversión significativa."

- Peor escenario = status quo. No pierdo nada sustancial.

En el trabajo:

- Encuadre = pérdida potencial. "Arriesgo mi credibilidad, podría violar políticas, puedo generar errores visibles."

- Peor escenario = daño reputacional, sanción, percepción de incompetencia.

Un gerente de finanzas con 15 años perfeccionando modelos en Excel no evalúa la IA solo por su capacidad técnica.

La evalúa contra la pérdida de identidad profesional que representa devaluar ese expertise que define su posición en la jerarquía.

El Status Quo Tiene Legitimidad Institucional

En tu vida personal, no existe "el método correcto" para planificar vacaciones. Cualquier herramienta vale.

En el trabajo, los procedimientos establecidos tienen legitimidad institucional acumulada.

Hay manuales, capacitaciones históricas, validaciones de auditoría, jurisprudencia interna sobre "cómo se hace aquí".

Adoptar la IA implica desafiar esa legitimidad, con costos sociales invisibles pero reales:

- Costos de coordinación: Ahora debo alinear mi nuevo método con el equipo, modificar flujos establecidos, negociar nuevas normas de calidad.

- Costos de aprendizaje social: ¿Es aceptable usar la IA para emails a clientes? ¿Para presentaciones ejecutivas? ¿Para análisis de datos sensibles? Esta ambigüedad normativa genera parálisis.

- Costos de señalización: Usar la IA visiblemente puede interpretarse como innovación (positivo) o como un nivel de incompetencia que requiere muletas tecnológicas (negativo). Esta ambigüedad es paralizante.

Los tres obstáculos sistémicos invisibles

1. Arquitectura de incentivos que penaliza la adopción

Tu organización mide y recompensa horas trabajadas, volumen de transacciones procesadas, cumplimiento de deadlines tradicionales.

Estos sistemas heredados penalizan implícitamente la adopción de IA:

- Penalización de curva de aprendizaje: Durante las primeras 3-4 semanas experimentando con la IA, la productividad medida por las métricas tradicionales cae antes de incrementarse. El colaborador que prioriza su evaluación trimestral evitará esta inversión con retorno diferido.

- Invisibilidad del impacto: Cuando un analista usa la IA para reducir una tarea de 4 horas a 45 minutos, tu sistema de "horas facturables" o "proyectos completados por semana" no captura esta ganancia de eficiencia. Peor: puede interpretarse como capacidad ociosa que justifica asignarle más trabajo sin reconocimiento.

El colaborador racional oculta su uso de IA y usa el tiempo liberado en actividades de menor valor pero mayor visibilidad organizacional.

2. Opacidad de Consecuencias (Incertidumbre Paralizante)

En el uso personal de la IA, el riesgo es transparente y manejable. En el uso organizacional, existe opacidad fundamental sobre las consecuencias:

- ¿Mi uso de IA está siendo monitoreado? ¿Cómo se interpreta?

- ¿Los errores atribuibles a la IA afectarán mi trayectoria profesional?

- ¿Qué normativas regulatorias estoy violando inadvertidamente?

- ¿Cómo evaluarán mi competencia superiores y pares?

Los humanos somos extremadamente adversos a la incertidumbre (más que al riesgo con probabilidades conocidas).

El uso de IA organizacional se mueve en el territorio de la incertidumbre. Como consecuencia la respuesta racional es de evitación absoluta.

3. Asimetría de Accountability (Cultura de Culpa)

Muchas organizaciones exhiben lo que los especialistas llaman la "cultura de la culpa": errores individuales castigados sin análisis de causas sistémicas.

Esto interactúa de forma perniciosa en contra de la adopción de la IA:

- Escenario A: El colaborador usa Excel, comete un error → es interpretado como "error humano normal, parte del riesgo operativo esperado."

- Escenario B: El colaborador usa la IA, comete un error → cuestionan su juicio de usar la herramienta, su capacidad de validación crítica, potencialmente su conformidad con políticas.

Esta asimetría crea un desincentivo poderoso. El uso de IA aumenta el escrutinio sobre errores que serían considerados normales con métodos tradicionales.

Adicionalmente, las políticas corporativas ambiguas ("usar con precaución", "sujeto a aprobación del supervisor" sin criterios claros) generan zonas grises donde el colaborador asume todo el riesgo de interpretación.

La respuesta racional del colaborador: evitar el uso de la IA en su trabajo.

La Solución No Es Tecnológica: Es Sistémica

Del Mandato a la Arquitectura de Elección

La solución requiere abandonar el paradigma de "implementación tecnológica con expectativa de adopción espontánea" hacia el "diseño de arquitectura de adopción que alinee la racionalidad individual con los objetivos organizacionales".

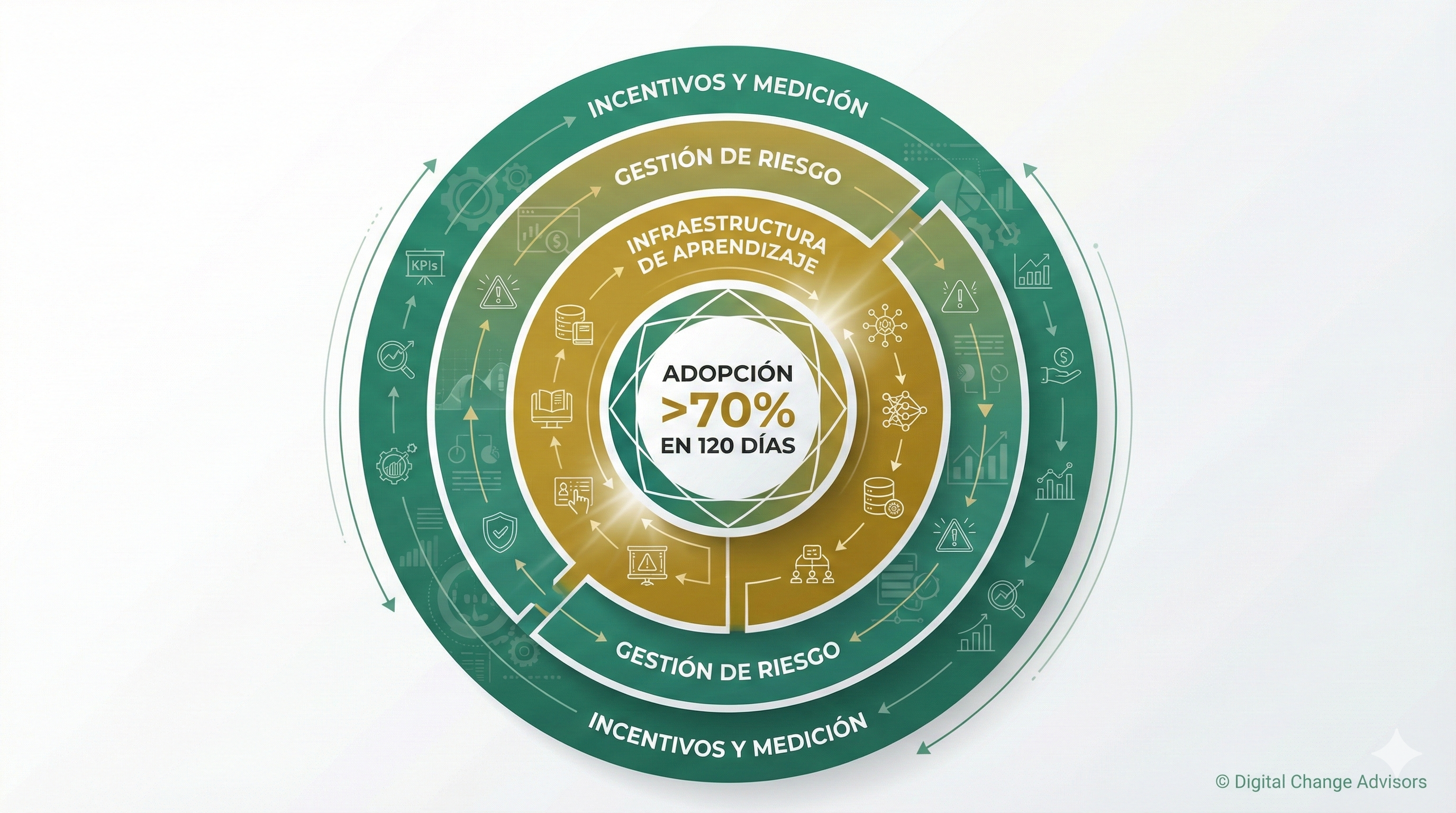

El Modelo ADA (Adopción Digital Acelerada) integra economía del comportamiento, neurociencias aplicadas y diseño organizacional para atacar simultáneamente los tres niveles donde se decide la adopción:

Nivel 1: Incentivos y Medición

- Transitar de medir inputs (horas) a outcomes: valor generado, impacto en el KPI que importa al negocio (Claridad en la contribución de valor).

- Incorporar la adopción de la IA en las evaluaciones de desempeño con una protección durante la curva de aprendizaje.

- Reconocimiento visible peer-to-peer de los casos de uso exitosos en la empesa.

- El analista que produce en 3 horas lo que antes tomaba 20 debe ser recompensado por su eficiencia, no penalizado por una "menor dedicación".

Nivel 2: Gestión de Riesgo Percibido

- Clarificación normativa explícita: casos de uso aprobados con ejemplos concretos, casos prohibidos con justificación, procesos de validación específicos por nivel de criticidad. (Gobernanza ágil)

- Redistribución del accountability: la organización asume la responsabilidad por la decisión estratégica de adoptar la IA; los colaboradores mantienen su responsabilidad sobre la validación de los outputs

- Seguro psicológico institucionalizado: amnistía documentada para errores de buena fe, compromiso de no-retaliación, canal confidencial para expresar preocupaciones.

Nivel 3: Infraestructura de Aprendizaje

- Tiempo protegido para experimentación sin expectativa de productividad inmediata.

- Programas de mentoring interno peer-to-peer (la influencia horizontal es más valiosa que la capacitación sin impacto).

- Biblioteca institucional de prompts efectivos y casos de uso documentados por función.

- Comunidades de práctica que simultáneamente aceleran el aprendizaje técnico y establecen las normas sociales pro-adopción de la IA.

Timeline Realista: 120 Días con Impacto Medible

Las organizaciones que han implementado este enfoque sistémico reportan resultados en 4 meses, no en un año y medio o dos años:

Mes 1: Fundamentos

- Clarificación normativa (eliminar ambigüedad paralizante).

- Protecciones de accountability para errores de buena fe.

- Identificación de casos de uso de bajo riesgo, alto valor.

Meses 2 y 3: Construcción de Confianza

- Foco en aplicaciones de bajo riesgo.

- Experimentos documentados con los primeros resultados.

- Comunicación de historias de éxito internas con protagonistas identificables.

Mes 4: Cambio Sistémico

- Modificación de la evaluación que recompense la adopción efectiva.

- Expansión del modelo de aprendizaje por ciclos de aplicación en campo.

- Normalización social del uso de IA como "la forma en que trabajamos aquí".

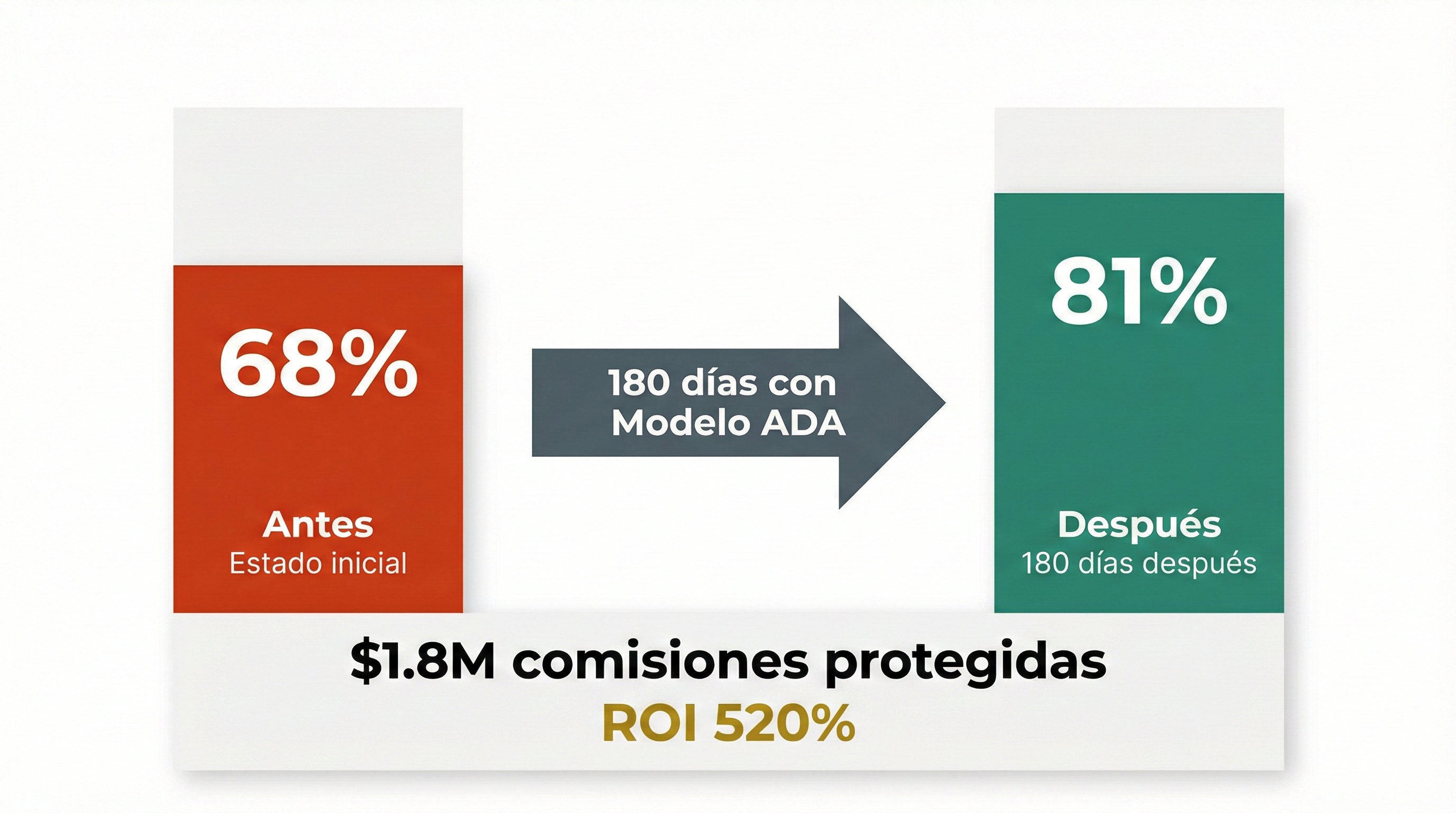

Caso Real: De 68% a 81% de Persistencia en 180 Días

Una firma de wealth management enfrentaba exactamente esta paradoja.

Sus asesores usaban la IA personalmente pero ignoraban el sistema predictivo de churn que la empresa había implementado con IA. Adopción: 21%.

El diagnóstico reveló el patrón clásico: los asesores percibían el sistema como una amenaza (pérdida de autonomía, cuestionamiento de su intuición experta) más que como una herramienta.

La intervención no fue tecnológica. Fue sistémica:

- Realinearon incentivos: Bonos de 50% ventas / 50% retención (antes 100% de los bonos eran con base en las ventas).

- Clarificaron riesgo: Los asesores fueron autorizados para ofrecer una "sesión estratégica gratuita" a los clientes en riesgo, sin aprobación previa. (antes requerían 3 niveles de aprobaciones).

- Crearon infraestructura de aprendizaje ágil: 4 sprints de aplicación práctica en retención proactiva con casos reales en el campo, no con simulaciones.

Resultado en 180 días:

- Persistencia al 13º mes: 68% → 81%

- Adopción de alertas IA: 21% → 84%

- AUM retenido: $54M adicionales

- Comisiones protegidas: $1.8M anualizados

- ROI de intervención: 520% año 1

La lección: No compraron mejor tecnología. Construyeron un mejor sistema para acelerar la adopción de las soluciones con IA.

De La Consciencia a La Acción

Hemos recorrido un territorio incómodo: tu inversión de $2.1M no está fallando por la tecnología.

Está fallando porque inadvertidamente diseñaste un sistema organizacional que hace racional para cada colaborador individual no adoptar la IA.

La buena noticia: esto tiene solución estructural y predecible.

La mala: no se resuelve con más comunicación, más capacitación, o "gestión del cambio" genérica.

Requiere rediseño sistémico de incentivos, riesgos y aprendizaje.

Si lo que acabas de leer resuena como un diagnóstico de tu realidad, hay dos caminos inmediatos como próximo paso a seguir:

- Primero, explora el Modelo ADA completo para entender cómo sus 14 componentes abordan de forma precisa los obstáculos estratégicos, organizacionales y psicológicos que frenan la adopción de la IA. No es teoría: es un sistema probado en 73 empresas con ROI promedio del 280% en el año 1.

- Segundo, únete a la Comunidad LADA donde más de 240 líderes de transformación digital están navegando exactamente estos desafíos. Es gratuita, cero spam, pura discusión estratégica entre pares que están en tu misma trinchera.

La Conversación del Lunes

Volvamos a esa sala de juntas. El Director Financiero sigue esperando tu respuesta sobre el ROI de los $2.1M invertidos en IA.

Con el marco que acabamos de explorar, ahora puedes articular una respuesta clara de algo que antes era solo una intuición incómoda:

"Compramos la tecnología correcta. Pero no habíamos diagnosticado la arquitectura de incentivos, riesgos y aprendizaje que estaba saboteando su adopción sistemáticamente.

Tengo un plan estructurado de 120 días para realinear esos sistemas usando el Modelo ADA, con métricas de progreso cada 30 días y casos de éxito probados en 73 empresas de la región."

No es la respuesta que querías dar hace 6 meses. Pero es la respuesta verdadera.

Y paradójicamente, esa honestidad diagnóstica restaura la confianza del comité, porque reconoce la realidad sin victimizarse.

La pregunta estratégica real no es "¿compramos mal?"

La pregunta es:

¿Vamos a seguir tratando la adopción de la IA como un problema de tecnología, o vamos a enfrentarlo como el desafío de estrategia organizacional que los datos demuestran que es?

Las empresas que hoy lideran la captura de ROI gracias a la IA no compraron mejor tecnología que tú.

Construyeron una mejor arquitectura de adopción de esta tecnología. Y esa arquitectura se puede diseñar, medir y escalar.

El KPI que importa no es cuántas licencias desplegaste.

Es qué porcentaje de tu equipo integra efectivamente IA en su trabajo diario con impacto medible en los KPIs que importan para negocio.

Esa métrica solo mejora cuando dejas de empujar la IA y empiezas a rediseñar los sistemas humanos dentro de los cuales esa tecnología exponencial opera.

Un abrazo,

César Lozano.